Come se il 2020 non fosse già abbastanza catastrofico, un team di accademici, esperti di politiche e addetti ai lavori dell’intelligenza artificiale ci avvertono di problemi all’orizzonte. 18, per la precisione. Sono le principali minacce dell’AI di cui dovremmo preoccuparci nei prossimi 15 anni.

Fantascienza e cultura popolare vogliono farci credere che la nostra rovina verrebbe da rivolte di robot intelligenti. In realtà uno studio recente su Crime Science rivela che la peggior minaccia avrà più a che fare con noi che con la stessa intelligenza artificiale.

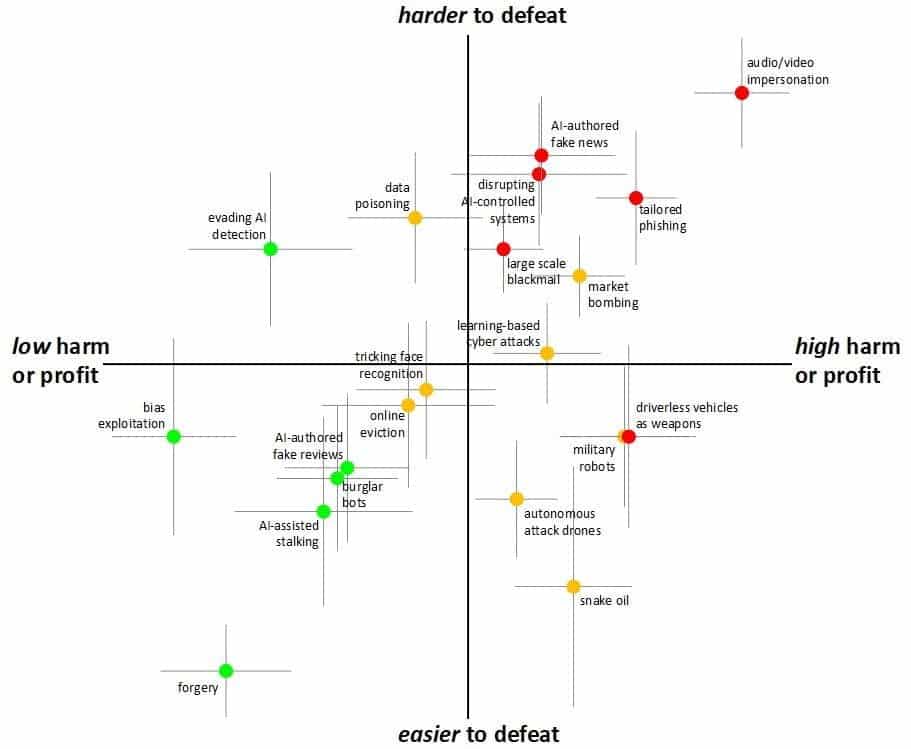

Valutando le minacce in base a potenziale danno, redditività, realizzabilità e sconfitta, il gruppo ha identificato che il deepfake, una tecnologia che già esiste e si sta diffondendo, rappresenta il livello di minaccia più elevato.

Deepfake, il nemico numero uno

C’è una differenza fondamentale tra una rivolta robotica e la tecnologia deepfake. La prima potrebbe produrre danni materiali. La seconda è sistemica: potrebbe causare l’erosione della fiducia nelle persone e nella stessa società.

La peggior minaccia dell’intelligenza artificiale può sempre sembrare qualcosa di lontano nel futuro. Dopo tutto, come può l’AI farci del male quando oggi Alexa non riesce nemmeno a impostare correttamente un timer per la pasta? Shane Johnson, Direttore del Dawes Center for Future Crimes presso l’UCL che ha finanziato lo studio, spiega che queste minacce diventeranno sempre più sofisticate e intrecciate con la nostra vita quotidiana.

“Viviamo in un mondo in continua evoluzione che crea nuove opportunità, buone e cattive”, avverte Johnson. “Per questo è prioritario anticipare le future minacce di criminalità in modo che i responsabili politici e altri con la competenza per agire possano farlo prima che si verifichino guai seri”.

Gli autori ammettono che i giudizi espressi in questo studio sono di natura intrinsecamente speculativa e influenzati dal nostro attuale panorama politico e tecnico, ma il futuro di queste tecnologie non può essere ignorato.

Come è nata la “playlist” delle peggiori minacce

Per formulare le loro previsioni sul futuro, i ricercatori hanno riunito un team di 14 accademici in settori correlati, sette esperti del settore privato e 10 esperti del settore pubblico.

Questi esperti sono stati poi divisi in gruppi da quattro a sei persone e hanno ricevuto un elenco di potenziali problemi che l’intelligenza artificiale potrebbe creare. Scenari che vanno dalle minacce fisiche (attacchi di droni autonomi) a forme digitali di minaccia come il phishing.

Per esprimere il proprio giudizio, il team ha considerato quattro caratteristiche principali degli attacchi:

Potenziale danno

Redditività

realizzabilità

Vulnerabilità

Per gli esperti i danni del deepfake sarebbero materiali, mentali ed anche sociali. Potrebbero portare danni anche ad altre intelligenze artificiali (ad esempio eludendo il riconoscimento facciale) o essere frutti indiretti (ad esempio ricattare delle persone utilizzando un video deepfake).

Sebbene questi fattori non possano essere davvero separati l’uno dall’altro (ad esempio il danno di un attacco, in realtà, potrebbe dipendere dalla sua realizzabilità), agli esperti è stato chiesto di considerare separatamente l’impatto di questi criteri.

I punteggi dei vari gruppi di esperti sono stati quindi ordinati per determinare gli attacchi complessivamente più dannosi che attraverso l’AI (o per opera di una AI) potremo vedere nei prossimi 15 anni.

L’imbarazzo della scelta

Confrontando 18 diversi tipi di minacce di AI, come detto, il gruppo ha stabilito che le manipolazioni video e audio sotto forma di deepfake sono le peggiori minacce in assoluto.

“Gli esseri umani hanno una forte tendenza a credere ai propri occhi e alle proprie orecchie. Per questo alle prove audio e video è stato tradizionalmente dato molto credito (e spesso valore legale), nonostante una lunga storia di inganni fotografici”, spiegano gli autori. “Ma i recenti sviluppi nel deep learning (e nei deepfake) hanno notevolmente aumentato le possibilità di generazione di contenuti falsi”.

Il potenziale impatto di queste manipolazioni?

Da individui che truffano gli anziani impersonando un membro della famiglia a video progettati per seminare sfiducia in personaggi pubblici e governativi. Attacchi difficili da rilevare per gli individui (e anche per gli esperti in alcuni casi) e difficili da fermare.

Altre minacce principali includono veicoli autonomi utilizzati come armi remote. È interessante notare che il gruppo ha giudicato i robot ladri (piccoli robot che possono arrampicarsi attraverso le grondaie per rubare le chiavi o aprire la porta a ladri umani) come una delle minacce meno pericolose.

Le peggiori minacce dell’AI. Allora siamo spacciati?

No, ma dobbiamo lavorarci su. Nel nostro immaginario ottimistico esiste una specie di pulsante per fermare tutti i robot e tutti i computer malvagi.

In realtà, la minaccia non è tanto nei robot stessi. È nel modo in cui li usiamo per manipolarci e danneggiarci a vicenda.