Se sorridete a qualcuno e non risponde, probabilmente lo troverete scoraggiante. No? Bene, questo robot vi darebbe maggiori soddisfazioni di qualche vicino di casa.

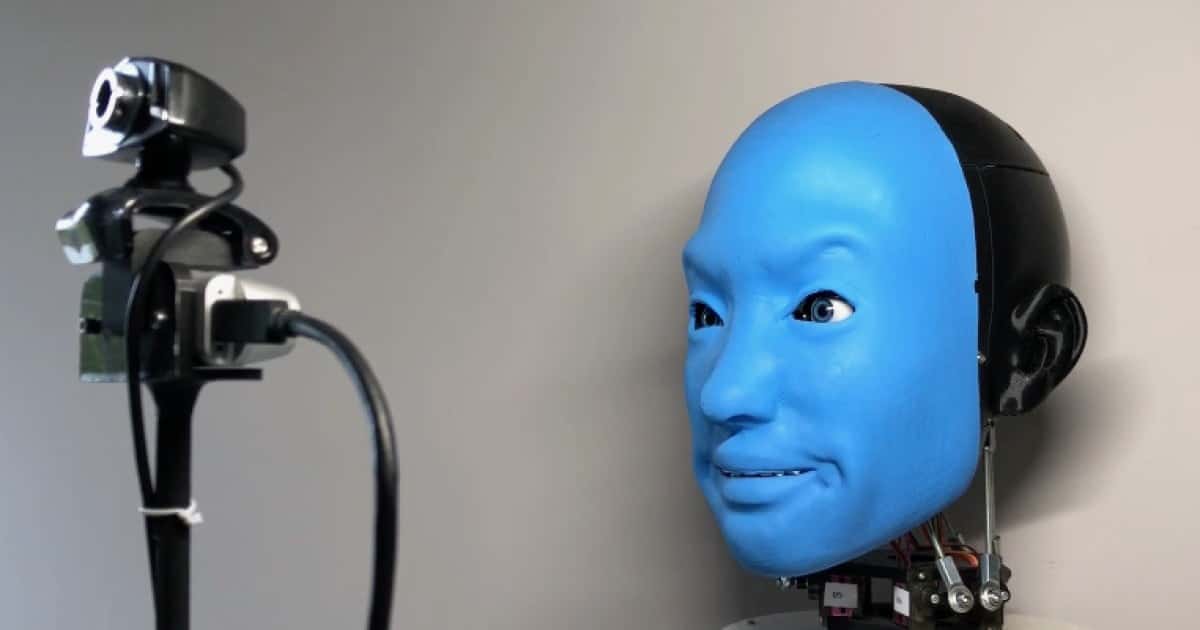

Sviluppato da un team di ricercatori di ingegneria presso la Columbia University di New York City, il progetto EVA è in realtà una testa robotica umanoide. È progettato per esplorare le dinamiche delle interazioni uomo/robot attraverso le espressioni facciali. Consiste in un teschio sintetico adulto, stampato in 3D, con una faccia in gomma morbida sul davanti.

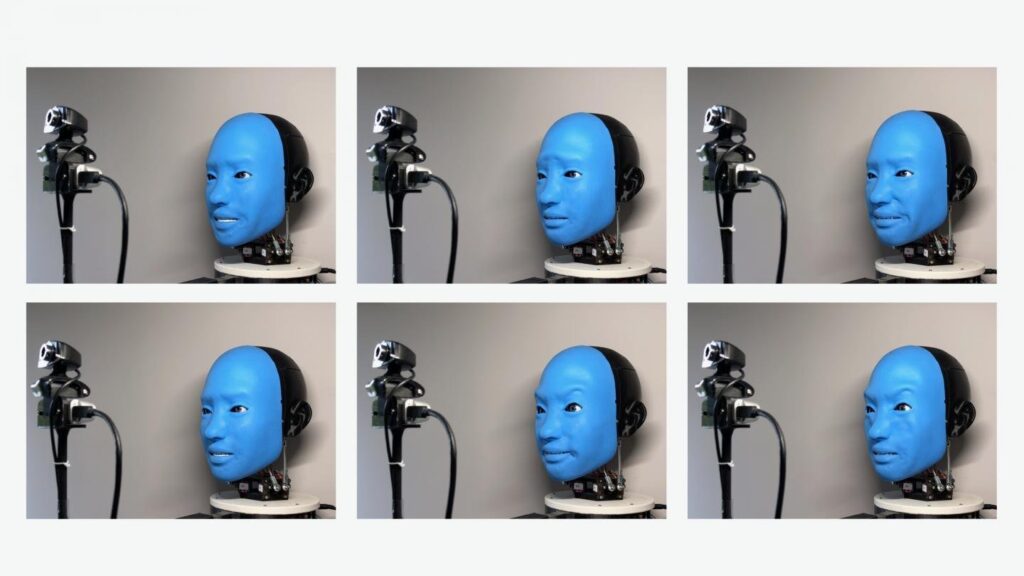

I motori all’interno del cranio tirano e rilasciano selettivamente i cavi attaccati a varie posizioni sulla parte inferiore del viso, proprio come i muscoli sotto la pelle dei nostri volti ci consentono di mostrare diverse espressioni facciali. Da parte sua, EVA può esprimere emozioni come rabbia, disgusto, paura, gioia, tristezza e sorpresa, oltre a “una serie di emozioni più sfumate”.

Un robot che imita le nostre espressioni facciali

Per sviluppare le sue capacità di scimmiottare le espressioni facciali, gli scienziati hanno iniziato a filmare l’EVA mentre muoveva casualmente la sua faccia. Quando il computer che controlla il robot ha successivamente analizzato le ore di riprese, ha utilizzato una rete neurale integrata per apprendere quali combinazioni di “movimento muscolare” risultassero corrispondenti ad espressioni facciali umane.

Nella seconda fase di “formazione”, quando una telecamera connessa ha ripreso il volto di una persona che interagiva con il robot, è stata utilizzata una seconda rete neurale per identificare le espressioni facciali di quell’individuo e abbinarle visivamente a quelle che il robot era in grado di creare. Il robot ha quindi proceduto ad assumere quelle “facce” muovendo i suoi muscoli facciali artificiali.

È utile?

Sebbene gli ingegneri ammettano che la semplice imitazione delle espressioni facciali umane possa avere applicazioni limitate, credono che potrebbe comunque essere utile. Non è un caso che tanti laboratori stiano lavorando sulla riproduzione delle espressioni facciali. Ad esempio, potrebbe aiutare a far progredire il modo in cui interagiamo con le tecnologie assistive.

“C’è un limite a quanto noi umani possiamo interagire emotivamente con chatbot basati su cloud o assistenti vocali”, dice il capo del progetto, il prof. Hod Lipson. “Il nostro cervello sembra rispondere bene ai robot che hanno una sorta di presenza fisica riconoscibile”.

Non ditemi che la prossima generazione di Google Nest o di Alexa sarà una testa che mi parla, perchè strippo. Me ne vado, eh?

Potete vedere l’EVA mentre scimmiotta espressioni facciali in questo video.