Con una diretta live su YouTube alle 21 ora italiana, OpenAI ha presentato il suo nuovo gioiellino, GPT-4, che si colloca su un livello decisamente superiore rispetto alla versione precedente, lanciata appena pochi mesi fa. Ora “l’esperto di conversazione” ChatGPT non è solo più potente, ma è in grado anche di “vedere”. E questo fattore può dare il via ad una accelerazione senza precedenti nello sviluppo dell’intelligenza artificiale.

Da GPT-3 a GPT-4 passa un mare

ChatGPT, il “piccolo genio elettronico” di OpenAI che risponde ai messaggi con testo e codice, è diventata in pochissimo tempo l’app in più rapida crescita nella storia, con oltre 100 milioni di utenti al mese.

Parallelamente al suo sviluppo sono nate comunità di utenti, guide all’uso (ne ho pubblicata una anche io: se vi interessa la trovate su Amazon) e perfino una “proto-professione”, quella del prompt engineer.

Tuttavia, nonostante il suo successo, ChatGPT aveva qualche problemino da risolvere. Tendeva ad “allucinarsi”, generando testi che suonavano verosimili ma non lo erano. Rifletteva dei pregiudizi, talvolta “bucava” i filtri per le frasi illecite previsti dai suoi creatori.

La nuova versione basata su GPT-4 risolve in buona parte questi problemi, e migliora (di molto) le prestazioni.

Occhi aperti sul mondo

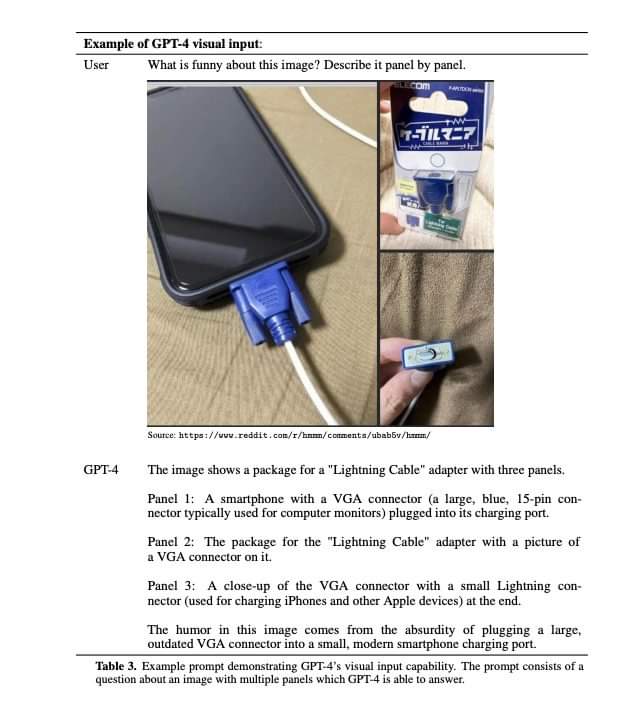

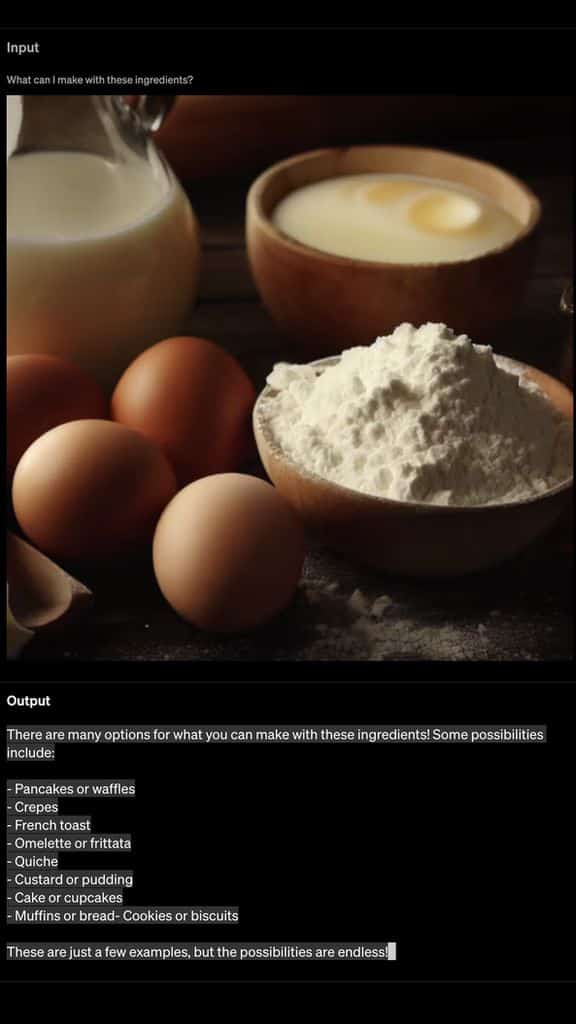

La grande novità di questo modello è la sua capacità di rispondere a prompt sia testuali che visivi. Pensate alle possibilità: identificare l’autore di un quadro, spiegare il significato di un meme, creare didascalie per fotografie… La verità è che il campo delle possibili applicazioni si allarga così tanto da rendere gigantesco un possibile elenco.

Ma GPT-4 non si ferma qui: è anche parecchio più “intelligente” del suo predecessore, superando i suoi risultati in diversi test, come quelli per le professioni legali (LSAT), quelli usati per l’ammissione nei college americani (SAT), e molti altri. OpenAI afferma che GPT-4 è il 40% più preciso nel generare contenuti veritieri e l’82% meno incline a rispondere a prompt illeciti (addio versioni “malvagie” del chatbot).

Tutto il resto è storia

Ci interrogheremo molto sulle caratteristiche incredibili che le intelligenze artificiali generative acquisiranno sempre di più (e sempre più velocemente). Grazie alla sua capacità di “vedere”, GPT-4 alimenterà molte applicazioni che utilizziamo quotidianamente.

Anzitutto, come detto, la nuova ChatGPT (nella sua versione a pagamento), capace ora di elaborare testi fino a 25.000 parole: può riassumere, scrivere e riscrivere, gestire interi libri. GPT-4 è anche parte del motore di ricerca Bing. La Khan Academy lo sta utilizzando per creare un tutor virtuale per gli studenti, mentre Be My Eyes ha sviluppato un assistente AI in grado di analizzare e descrivere fotografie per persone con disabilità visive.

Stare dietro alle sue evoluzioni sarà sempre più complicato.

GPT-4, prospettive future

Ovviamente il sistema è ancora migliorabile, presenta ancora delle imperfezioni, ma il progresso è notevole e rapidissimo. L’azienda sta già esplorando come integrare anche input audio, video e altro nelle future versioni del modello. Il loro obiettivo è che GPT-4 diventi uno strumento prezioso per migliorare la vita delle persone, alimentando numerose applicazioni.

Tra un po’ questo aggeggio ci dirà anche cosa pensa dei nostri abiti, o ci consiglierà il taglio di capelli più adatto. Alimenterà sistemi di sorveglianza cui presentiamo i nostri amici e parenti, perché aprano subito soltanto a loro. Renderà le nostre automobili delle “supercar” che interagiscono in modo personale con il conducente. Sarà la “voce narrante” di tanti non vedenti, e li aiuterà a sentirsi più integrati. E chissà che altro.

Non posso indicarvi, come detto, tutti i punti d’arrivo: al massimo rimandarvi al punto di partenza con l’annuncio ufficiale sul blog di OpenAI, o con il video della presentazione di ieri, così vi fate voi stessi un’idea.

Per ora, però, diciamo “benvenuto” a questo straordinario tuttofare che, per chi ancora non lo avesse capito, ha già cambiato le nostre vite.