Ieri OpenAI ha incontrato il Garante italiano per la protezione dei dati personali, per affrontare le preoccupazioni sulla privacy che hanno portato al blocco temporaneo di ChatGPT in Italia. La chatbot di intelligenza artificiale è stata bloccata dalla stessa azienda americana, in via cautelare, dopo che i messaggi e le informazioni di pagamento di alcuni utenti sono stati esposti ad altri in un (disastroso) data breach il 20 marzo.

Si tratta del primo caso in cui una democrazia ha imposto un blocco su una piattaforma AI di tale portata. Un’operazione essa stessa non priva di polemiche e ombre. Ad ogni modo, OpenAI ha promesso di proporre misure per affrontare le preoccupazioni, anche se non sono ancora state del tutto dettagliate. La notizia arriva direttamente in una nota sullo stesso sito ufficiale dell’autorità italiana.

Parliamone

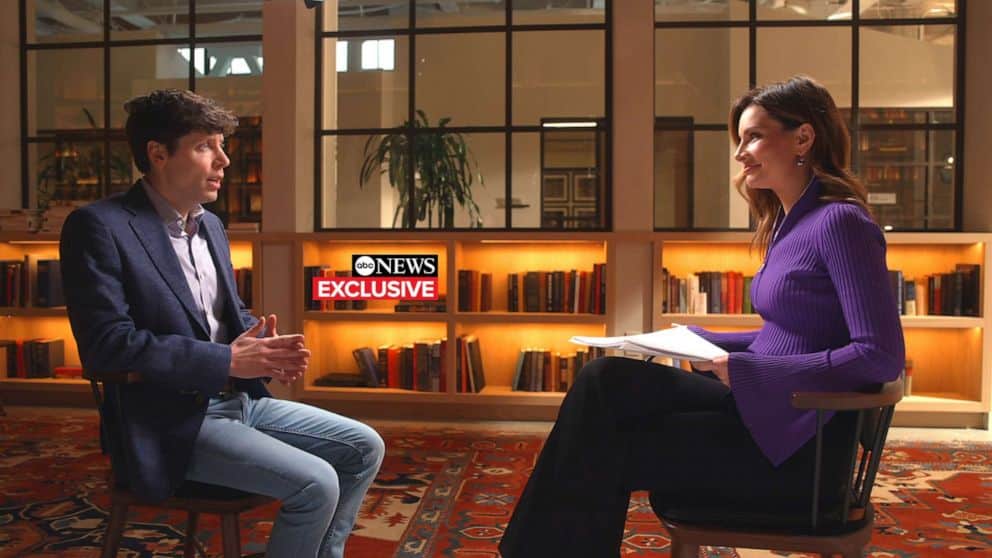

Nella videochiamata di ieri tra i commissari del Garante e i dirigenti di OpenAI, tra cui il CEO Sam Altman, abbiamo assistito alla prima, vera schiarita in tutta questa vicenda che sta tenendo (non scherzo) aziende e privati con il fiato sospeso (e il mouse sulle VPN, le cui iscrizioni sono schizzzate verso l’alto). Dal suo canto, l’azienda di Altman ha promesso di presentare misure per affrontare le preoccupazioni. Il Garante, invece, ha sottolineato l’importanza della conformità alle rigorose normative sulla privacy dei 27 paesi dell’UE. In particolare, ha messo in dubbio la base giuridica per la raccolta di enormi quantità di dati utilizzati per addestrare gli algoritmi di ChatGPT e ha sollevato preoccupazioni sulla possibilità che il sistema possa generare informazioni false su individui.

La schiarita del Garante

Il vero punto di tutta la vicenda, però, figlio probabile della forte fibrillazione di diversi settori (e di tantissimi utilizzatori) è stata la mano tesa dal Garante. I Commissari hanno espresso in modo molto chiaro il desiderio di non ostacolare lo sviluppo dell’AI in Italia. E questo non può che precludere ad un “felice” esito di tutta la vicenda.

Cosa succede adesso?

OpenAI ha dichiarato di essere al lavoro per rimuovere le informazioni personali dai dati di addestramento dove possibile, per settare i suoi modelli a rifiutare le richieste di informazioni personali di privati e per agire su richieste di cancellazione di informazioni personali dai suoi sistemi. Caso chiuso, quindi? Nì. In Italia, come detto, l’impressione è che si arriverà ad una riapertura del sistema. Più in generale, però, le autorità stanno “scaldando i motori” per recuperare il gap e provare a regolamentare il settore.

Altri regolatori in Europa e altrove hanno iniziato a prestare maggiore attenzione dopo l’azione dell’Italia. La Commissione irlandese per la protezione dei dati ha dichiarato di essere “in contatto con il Garante italiano per capire la base delle loro azioni e coordinarsi con tutte le autorità di protezione dei dati dell’UE in relazione a questa questione”. Il regolatore della privacy dei dati della Francia, CNIL, ha dichiarato di aver avviato un’indagine dopo aver ricevuto due denunce su ChatGPT. Anche il commissario per la privacy del Canada ha aperto un’indagine su OpenAI. E lo ha fatto dopo aver ricevuto una denuncia sulla presunta “raccolta, utilizzo e divulgazione di informazioni personali senza consenso”.

D’altra parte il viaggio dell’AI è solo all’inizio, giusto?