In un ambiente luminoso, pieno di monitor e apparecchiature tecnologiche, un robot si erge come protagonista. La sua struttura metallica riflette la luce, ma è nei suoi “occhi” che si nasconde la vera magia. Questi occhi, alimentati dal modello RT-2 di DeepMind, sono capaci di vedere, interpretare e agire.

Mentre il robot si muove con grazia, gli scienziati intorno a lui scrutano ogni sua mossa. Non è solo un pezzo di metallo e circuiti, ma l’incarnazione di un’intelligenza che unisce il vasto mondo del web con la realtà tangibile.

L’evoluzione di RT-2

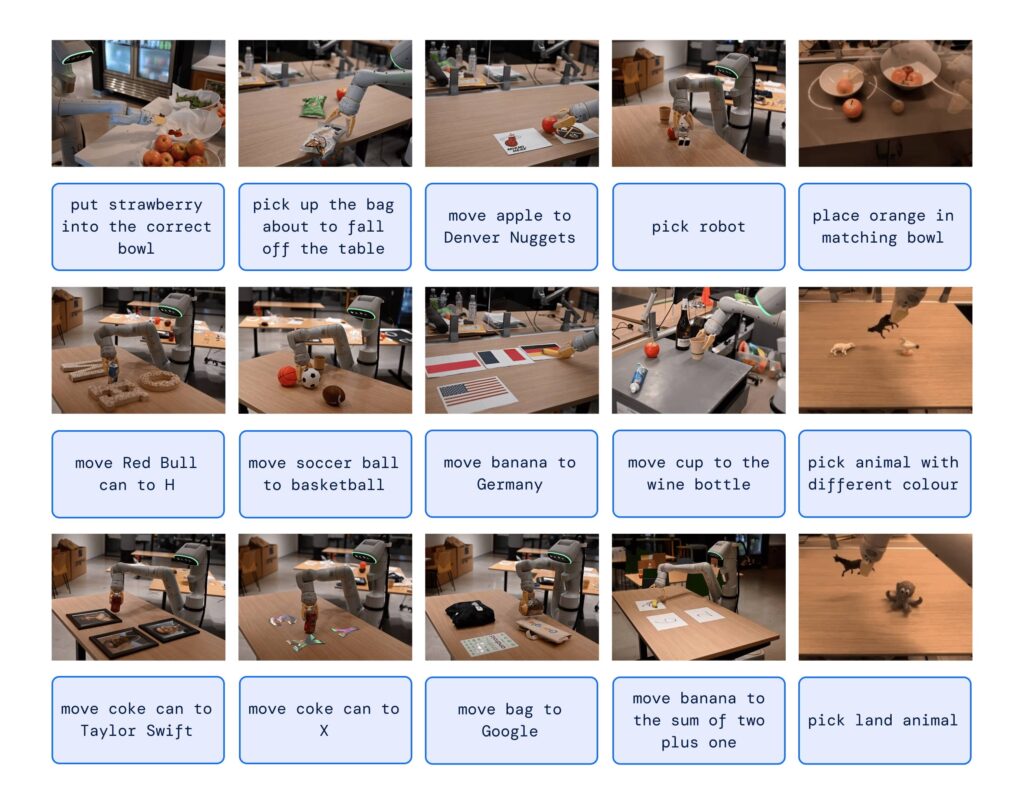

La robotica ha fatto passi da gigante negli ultimi anni, ma DeepMind ha appena portato il gioco a un livello completamente nuovo. Illustrato in un paper appena diffuso arriva RT-2. Cos’è? È un modello visione-linguaggio-azione (VLA) che non solo apprende dai dati del web, ma anche dai dati robotici, traducendo questa conoscenza in istruzioni generalizzate per il controllo robotico.

In un’era in cui la tecnologia avanza a passi da gigante, RT-2 rappresenta un balzo significativo, promettendo di rivoluzionare non solo il campo della robotica, ma anche il modo in cui viviamo e lavoriamo ogni giorno. Ma che significa in pratica?

DeepMind RT-2, da visione ad azione

I modelli di visione-linguaggio ad alta capacità (VLM) sono addestrati su grandi dataset, e questo li rende straordinariamente bravi anche nel riconoscere schemi visivi o linguistici (operando, ad esempio, in diverse lingue). Ma immaginate di poter far fare ai robot ciò che fanno questi modelli. Anzi, smettete di immaginarlo: DeepMind lo sta rendendo possibile con RT-2.

Robotic Transformer 1 (RT-1) era già una meraviglia di per sé, ma RT-2 va oltre, mostrando capacità di generalizzazione migliorate e una comprensione semantica e visiva che va oltre i dati robotici a cui è stato esposto.

Ragionamento a catena

Uno degli aspetti più affascinanti di RT-2 è la sua capacità di ragionamento a catena. Può decidere quale oggetto potrebbe essere usato come martello improvvisato o quale tipo di bevanda è la migliore per una persona stanca. Questa capacità di ragionamento profondo potrebbe rivoluzionare il modo in cui interagiamo con i robot.

E mal che vada, potreste comunque chiedere a un robot di prepararvi un buon caffè per ritrovare un po’ di lucidità.

Ma come fa DeepMind RT-2 a controllare un robot?

La risposta sta nel modo in cui è stato addestrato. Di fatto, usa una rappresentazione non dissimile ai token del linguaggio che vengono sfruttati da modelli come ChatGPT.

RT-2 ha dimostrato capacità emergenti sorprendenti, come la comprensione dei simboli, il ragionamento e il riconoscimento umano. Abilità che al momento mostrano un miglioramento di oltre 3 volte rispetto ai modelli precedenti.

Con RT-2, DeepMind non solo ha mostrato che i modelli di visione-linguaggio possono essere trasformati in potenti modelli visione-linguaggio-azione, ma ha anche aperto la porta a un futuro in cui i robot possono ragionare, risolvere problemi e interpretare informazioni per svolgere una vasta gamma di compiti nel mondo reale.

E ora?

In un mondo in cui l’intelligenza artificiale e la robotica saranno sempre più centrali, RT-2 ci mostra che la prossima evoluzione non sarà puramente tecnica, ma “percettiva”. Le macchine comprenderanno e risponderanno alle nostre esigenze in modi che non avremmo mai immaginato.

Se questo è solo l’inizio, chissà cosa ci riserva il futuro.