Lo scorso novembre Meta ha annunciato che avrebbe eliminato la sua tecnologia di tagging di riconoscimento facciale. Oggi anche Microsoft si pone sullo stesso piano, puntando a rassicurare i clienti. Ritirerà gradualmente la sua AI di riconoscimento facciale in grado di rilevare le emozioni (e non solo).

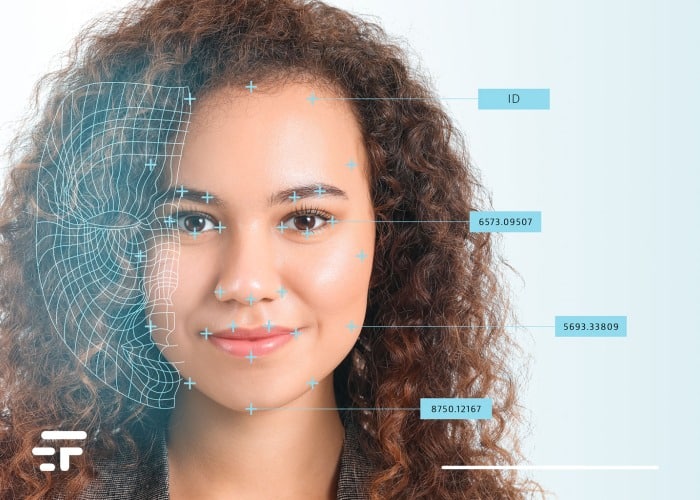

Secondo il portale Engadget questa tecnologia non è solo in grado di dire se sei triste, felice o arrabbiato. Con la sua capacità di identificare perfettamente caratteristiche come età, sesso e capelli, il software di intelligenza artificiale del gigante di Redmond ha sollevato immancabili (quanto legittime) polemiche sulla privacy.

Il lungo addio

In un post sul blog di Microsoft, leggo che i nuovi utenti del framework di programmazione Microsoft Face non potranno più accedere alle sue funzionalità. E i clienti già esistenti? Con calma: potranno attingere alla tecnologia “solo” fino al 30 giugno 2023.

La decisione rientra nel piano Microsoft per lo sviluppo e la diffusione della tecnologia di intelligenza artificiale. Una nuova strategia “più etica” che disporrà l’accesso ai software di riconoscimento facciale solo attraverso le piattaforme proprietarie Azure Face API, Computer Vision e Video Indexer.

Cesseremo le funzionalità di analisi facciale che pretendono di determinare emozioni e tratti dell’identità come il sesso, l’età, il sorriso, i peli del viso, i capelli e il trucco

Dal comunicato Microsoft

Tu chiamale, se vuoi, emozioni

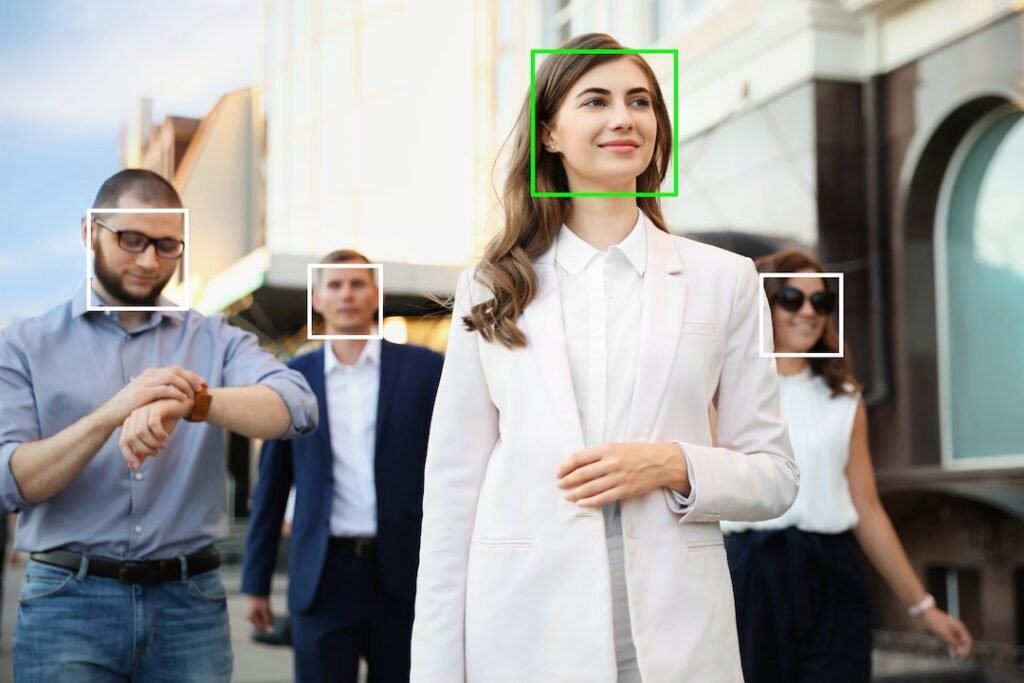

Inutile ribadirlo, lo immaginerete: l’accesso a funzioni con attributi sensibili apre ad un’ampia gamma di possibilità di abuso. Selezionare le persone sulla base di questi parametri rischia di sottoporle a pregiudizi, discriminazioni o ingiuste negazioni di servizi.

Via via che l’intelligenza artificiale diventa più potente, e prima che diventi senziente (checché se ne dica non è ancora così) serve attenzione. È ora che le grandi aziende prendano provvedimenti per garantire che la privacy e le informazioni dei consumatori non vengano compromesse, e che questa tecnologia non venga utilizzata per scopi dannosi.